أقدم سكريبت بايثون لجمع البيانات من أي موقع

أقدم سكريبت بايثون لجمع البيانات من أي موقع

وصف الخدمة

هل تحتاج إلى استخراج بيانات من موقع معين؟

سأقوم ببرمجة سكريبت Python مخصص لجمع بيانات (عناوين - أسعار - روابط - أخبار...) من أي موقع تختاره، باستخدام تقنيات مثل:

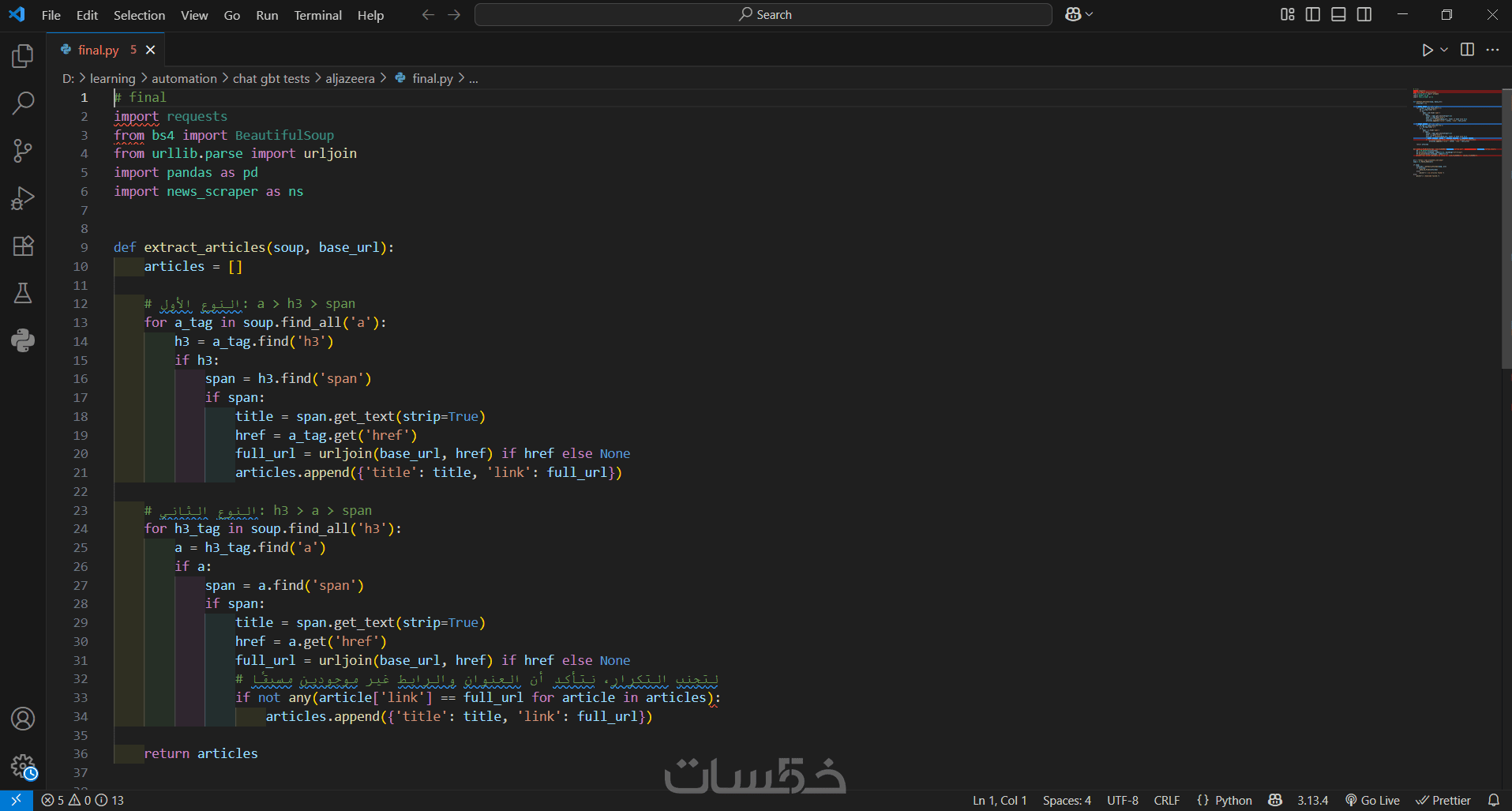

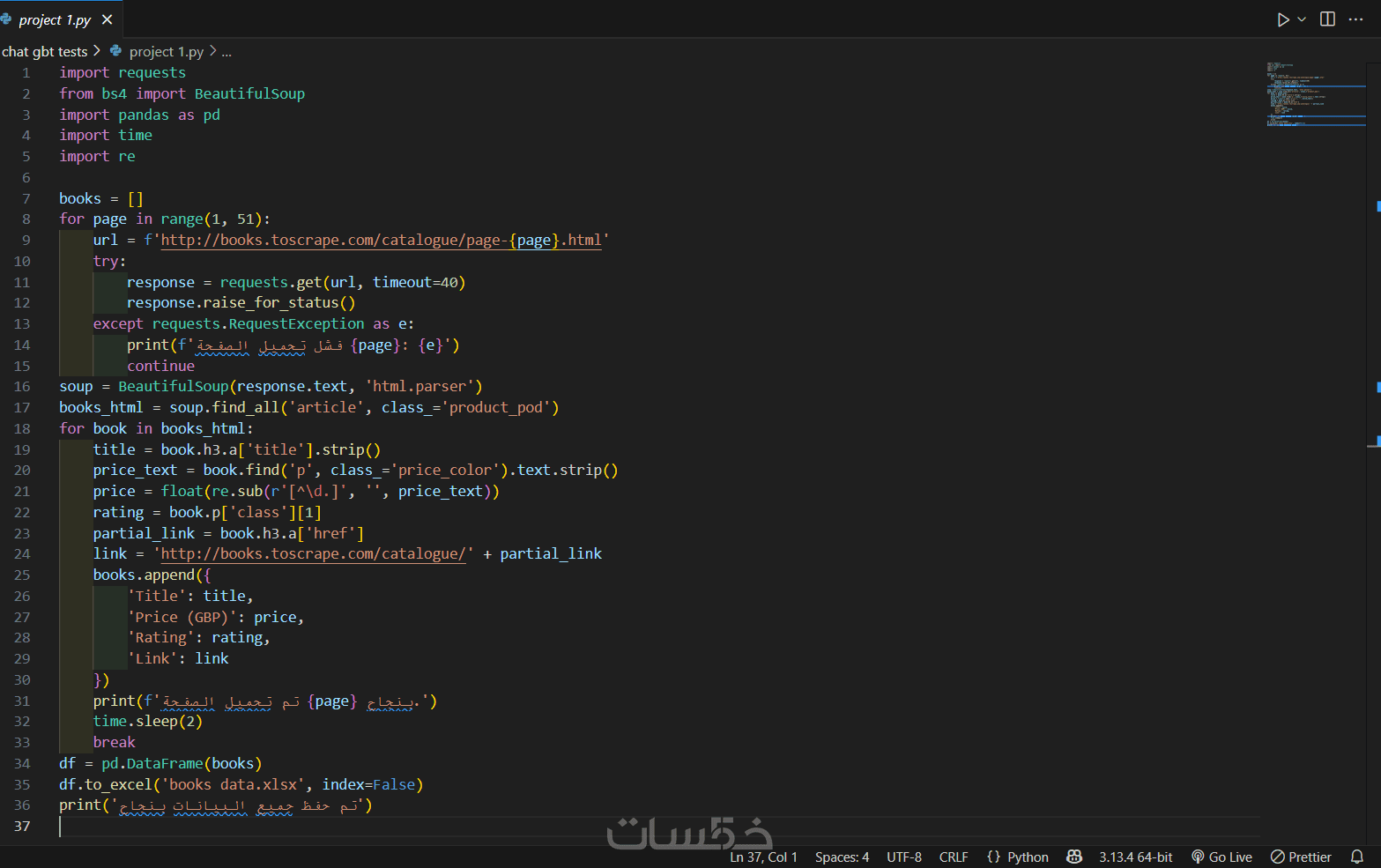

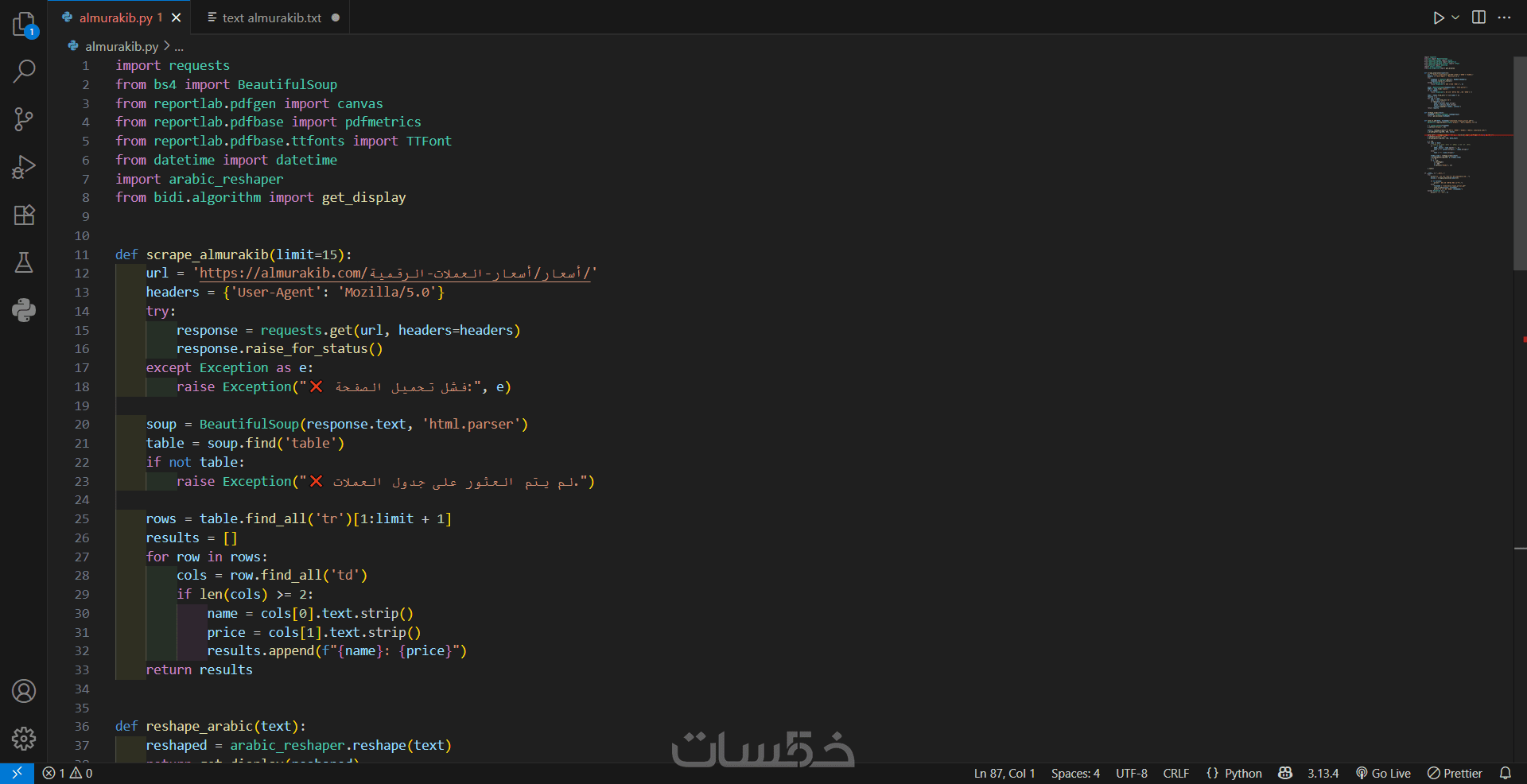

Web scraping عبر requests و BeautifulSoup

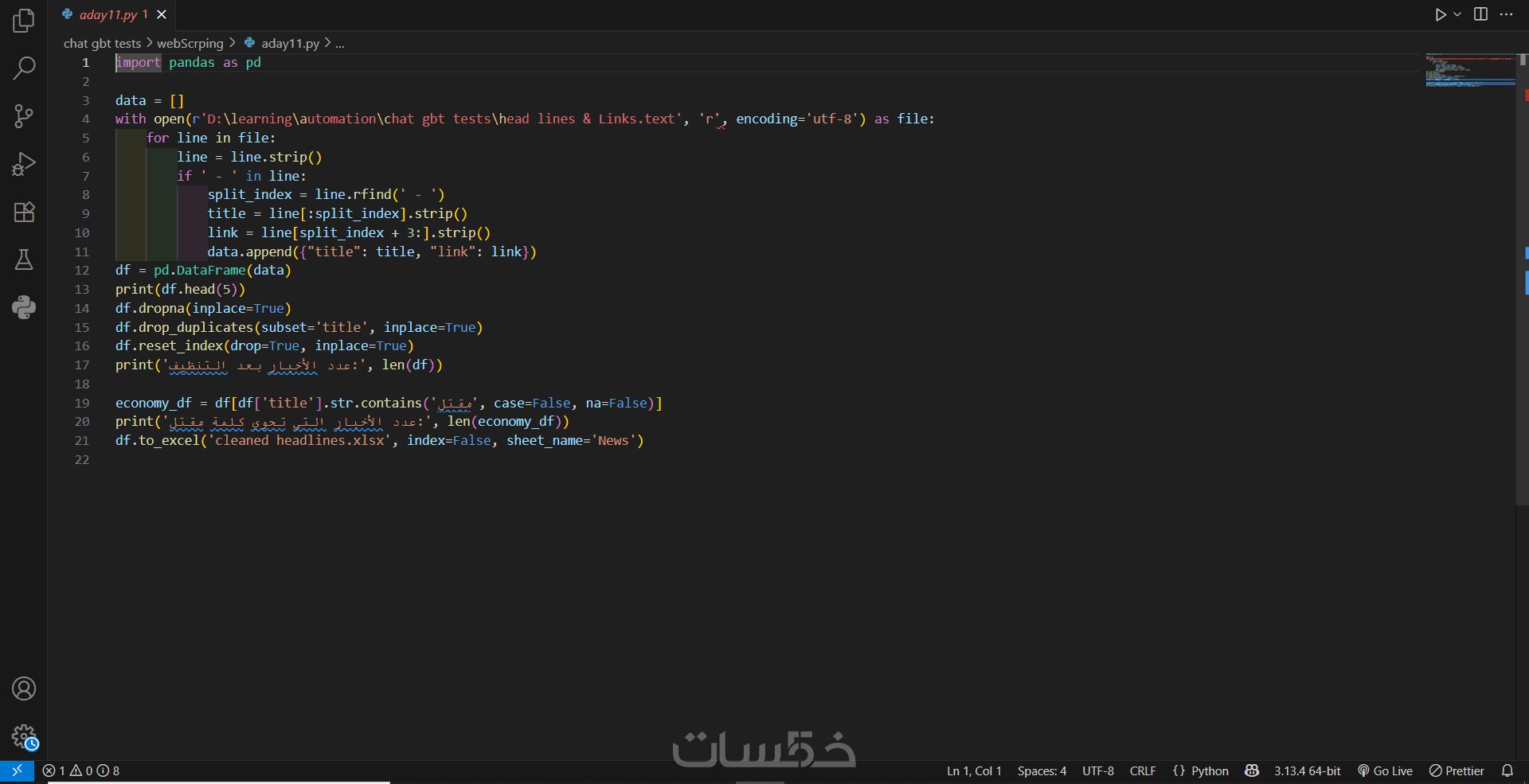

تحليل بنية HTML واستخراج البيانات المطلوبة

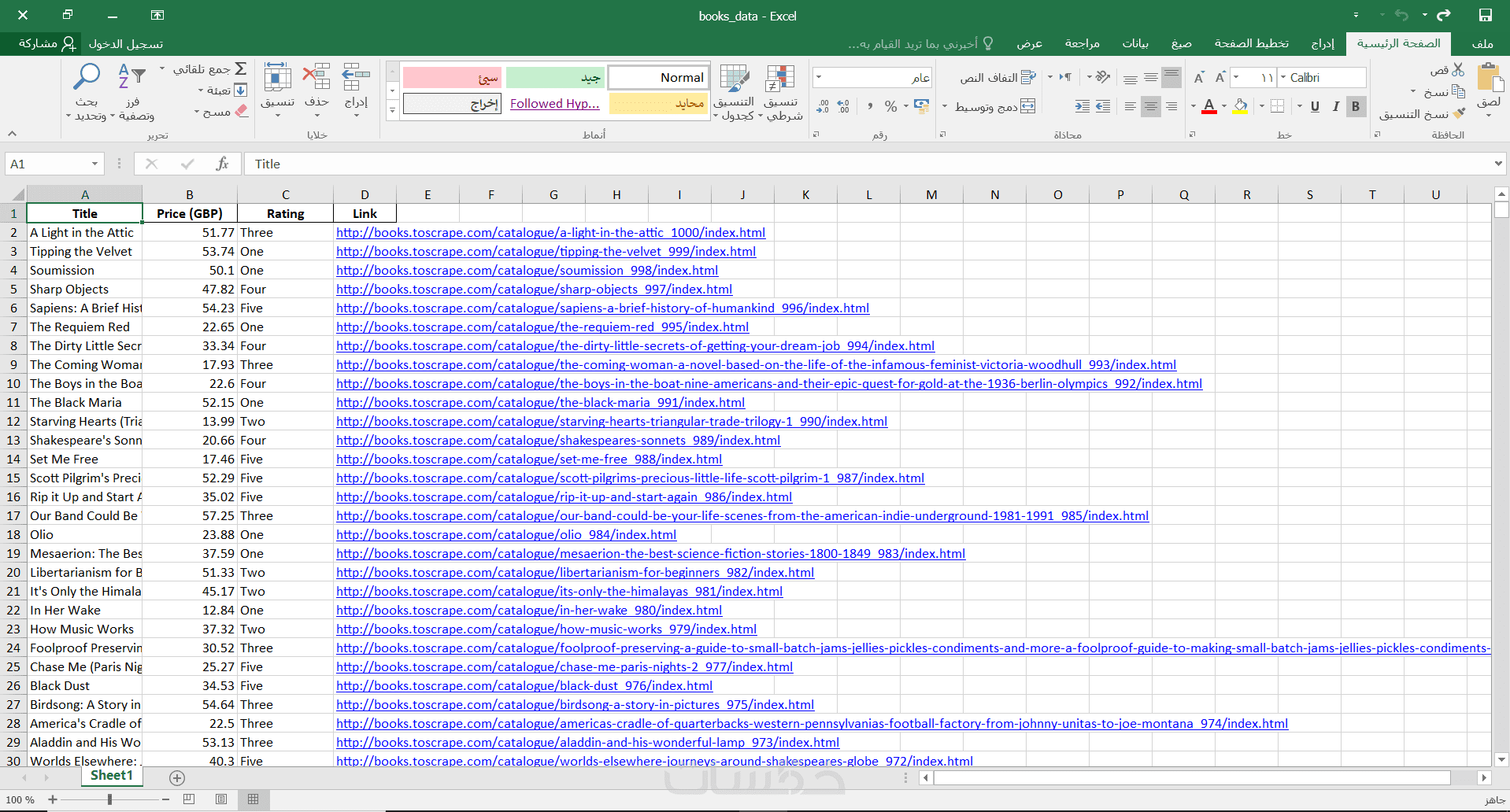

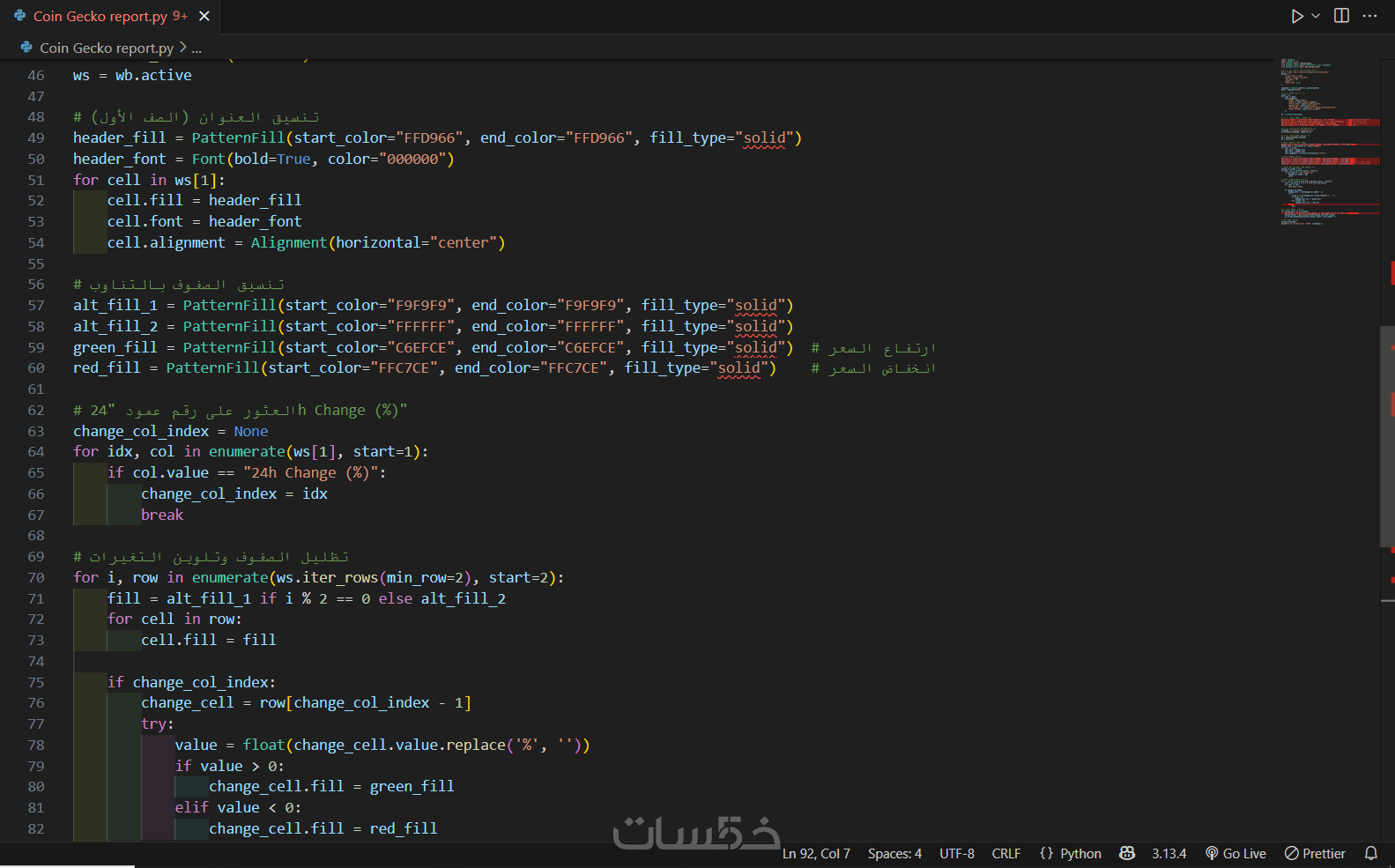

حفظ النتائج في ملفات Excel وCSVوPDF

دعم للمواقع العربية والإنجليزية

* أمثلة على ما أستطيع تقديمه:

جمع الأخبار من موقع إخباري مثل الجزيرة أو العربية

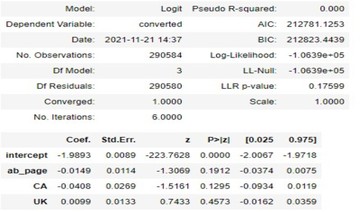

جمع المنتجات من موقع تجاري وتحليلها

استخراج مقالات أو محتوى من صفحات متعددة

* الخدمة الأساسية (صفحة واحدة - 50 عنصر كحد أقصى)

✔ السكريبتات قابلة للتعديل حسب احتياجك

✔ أتعامل باحترافية وبأسلوب مبسط

مميزات الخدمة

* تحليل ذكي لبنية الموقع

أقوم بتحليل بنية الموقع المستهدف بدقة لاستخراج البيانات المطلوبة حتى لو كانت مخفية داخل عناصر معقدة (داخل span أو div أو روابط).

* برمجة باستخدام Python

أستخدم مكتبات بايثون المتخصصة مثل BeautifulSoup, Requests, وPandas لضمان نتائج دقيقة ومنظمة.

* تسليم النتائج بصيغ متعددة

أُسلّم البيانات في ملف Excel أو CSV أو PDF، منسق وجاهز للاستخدام، حسب رغبتك.

* تسليم شرح السكريبت البرمجي

إذا كنت ترغب بالحصول على شرح السكربت نفسه لتقوم بتعديلات عليه لاحقًا.

* تجربة تعامل احترافية

أسعى دائمًا إلى تقديم خدمة عالية الجودة، وسأكون متعاونًا ومرنًا في تلبية طلباتك حتى تكون راضيًا 100%.

ما الذي ستستلمه

* سكريبت بايثون نظيف وجاهز للتشغيل

ستتلقى كود بايثون احترافيًا، مكتوبًا خصيصًا ليناسب احتياجاتك في جمع البيانات من الموقع المحدد. السكريبت سيكون نظيفًا ومنظمًا، وجاهزًا للتشغيل مباشرة على جهازك.

* البيانات المجمعة في صيغة سهلة الاستخدام:

ستحصل على البيانات التي طلبتها في صيغة منظمة وقابلة للتحليل. الخيارات المتاحة تشمل:

ملف CSV: (Comma Separated Values) مثالي للفتح والتعديل بسهولة باستخدام برامج الجداول الإلكترونية مثل Microsoft Excel أو Google Sheets.

ملف Excel, pdf, Word (حسب الرغبة)

* تعليمات تشغيل واضحة ومفصلة:

لا داعي للقلق إذا لم تكن لديك خبرة سابقة في البرمجة! سأقدم لك دليلًا بسيطًا يشرح كيفية تشغيل السكريبت بنجاح والحصول على البيانات المطلوبة.

* بالختام:

هذه الخدمة هي بوابتك للحصول على البيانات المنظمة التي تحتاجها لأبحاثك، تحليلاتك، أو أي غرض آخر بكل سهولة وفعالية.

كلمات مفتاحية

خدمات قد تنال إعجابك

شراء الخدمة

سعر الخدمة

$5.00

تطويرات اختيارية

جمع البيانات من عدة صفحات عن الموقع( 5 صفحات كحد أقصى)

5.00

|

بطاقة الخدمة

بطاقة الخدمة

شراء الخدمة

سعر الخدمة

$5.00

تطويرات اختيارية

جمع البيانات من عدة صفحات عن الموقع( 5 صفحات كحد أقصى)

5.00

|