استخراج البيانات من مواقع الويب باستخدام Python بدقة واحتراف

استخراج البيانات من مواقع الويب باستخدام Python بدقة واحتراف

وصف الخدمة

هل ترغب في جمع بيانات من مواقع إلكترونية متعددة بسرعة ودون عناء يدوي؟

سأقوم باستخراج البيانات من أي موقع إلكتروني بطريقة احترافية باستخدام Python ومكتبات BeautifulSoup وRequests وSelenium، وتنظيمها في ملفات Excel أو CSV أو JSON حسب طلبك.

الخدمة الأساسية تشمل:

• اقدم لك استخراج حتى 2000 من البيانات ضمن الخدمة الأساسي.

مميزات الخدمة

1. استخراج دقيق ومنظم للبيانات

أستخدم تقنيات Web Scraping متقدمة تضمن استخراج البيانات المطلوبة فقط من الصفحات المستهدفة، بدون تكرار أو بيانات ناقصة، مع تنسيقها في ملفات منظمة وسهلة القراءة.

2. دعم المواقع الديناميكية والمعقدة

أتعامل مع المواقع التي تعتمد على JavaScript أو التحميل الديناميكي باستخدام أدوات مثل Selenium لضمان جمع كل البيانات التي تظهر للمستخدم في المتصفح.

3. تخصيص كامل حسب متطلباتك

يمكنك تحديد بالضبط ما تحتاجه من عناصر — مثل الأسماء، الأسعار، التقييمات، أو الروابط — وسأبني كودًا مخصصًا لتلبية احتياجك بدقة.

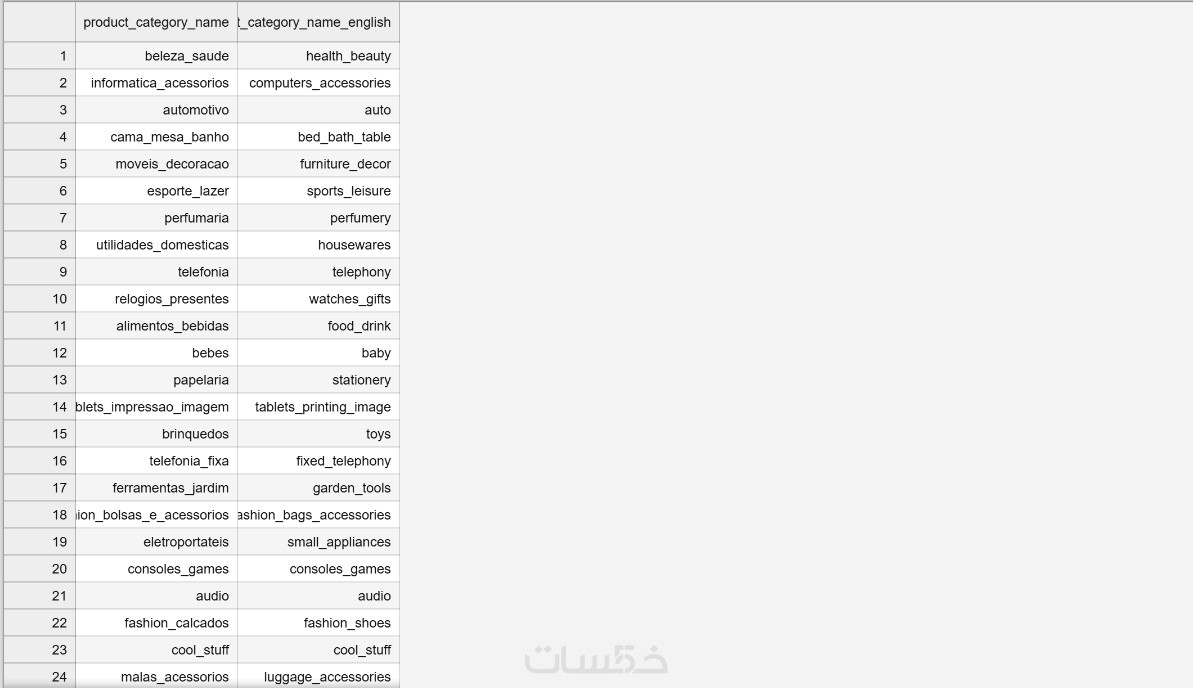

4. تسليم البيانات بأي صيغة ترغب بها

أوفر لك البيانات النهائية بصيغ متعددة مثل Excel، CSV، أو JSON، لتتمكن من استخدامها مباشرة في تحليلك أو مشروعك القادم.

5. سرعة التنفيذ واحترافية التواصل

أضمن لك إنجاز العمل في الوقت المحدد مع تواصل واضح وتحديثات مستمرة أثناء العملية، لضمان رضاك الكامل عن النتيجة.

ما الذي ستستلمه

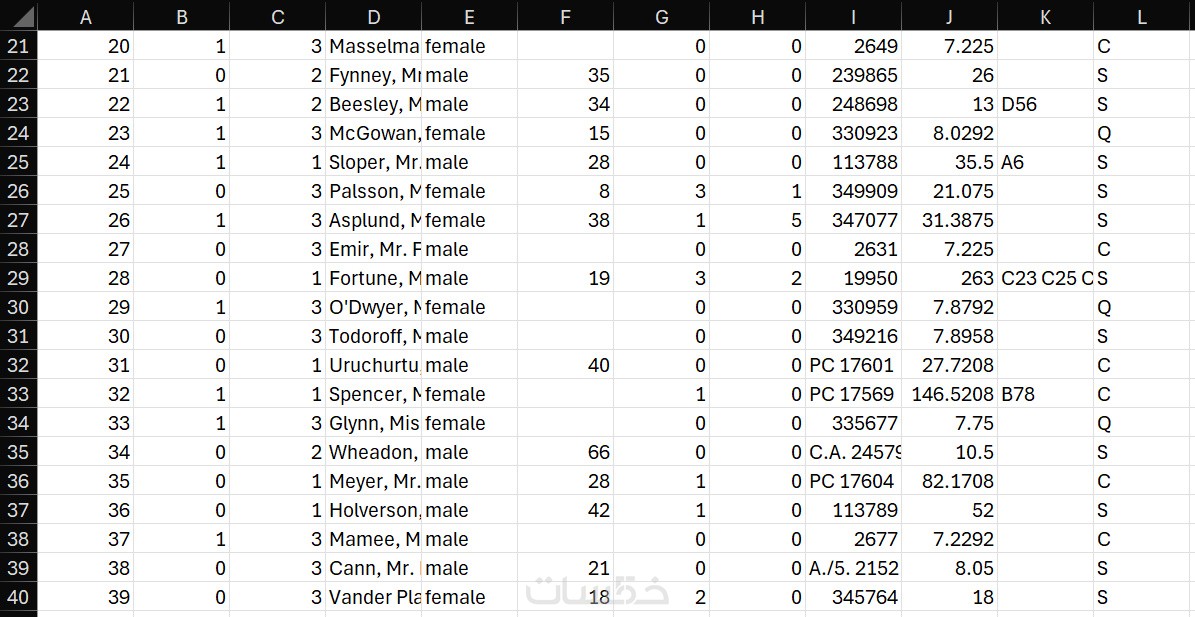

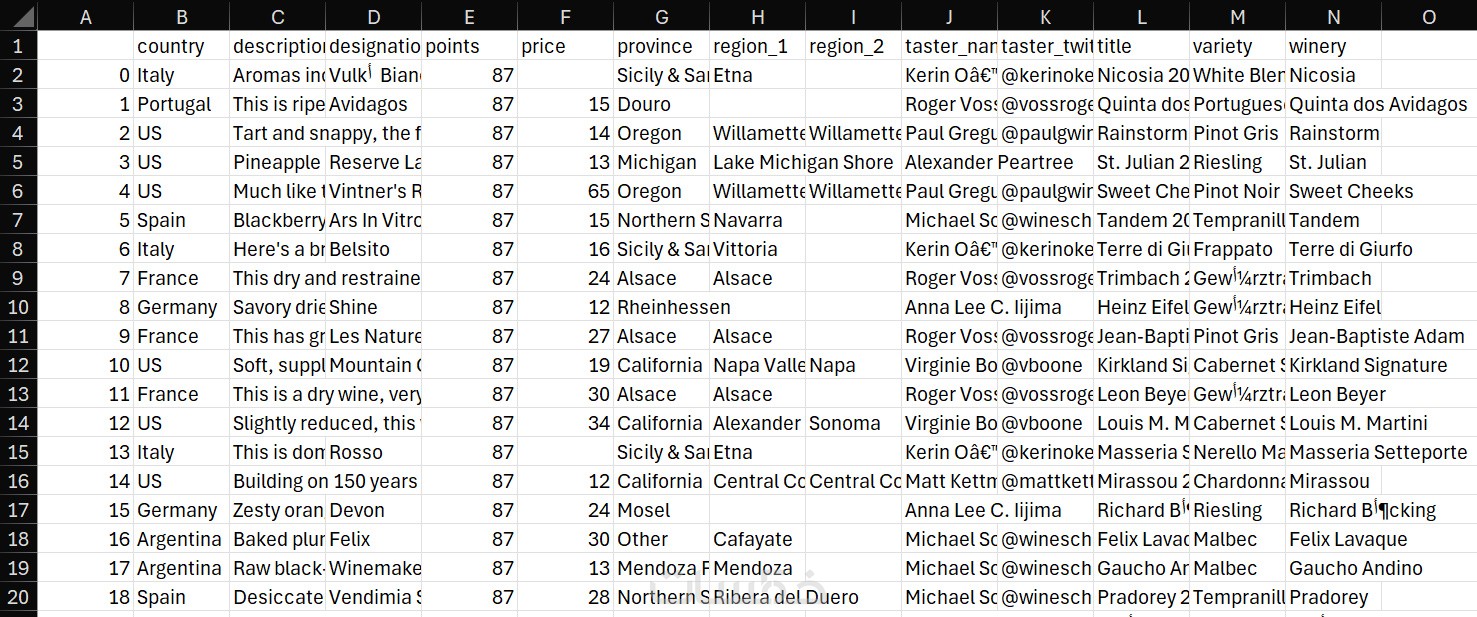

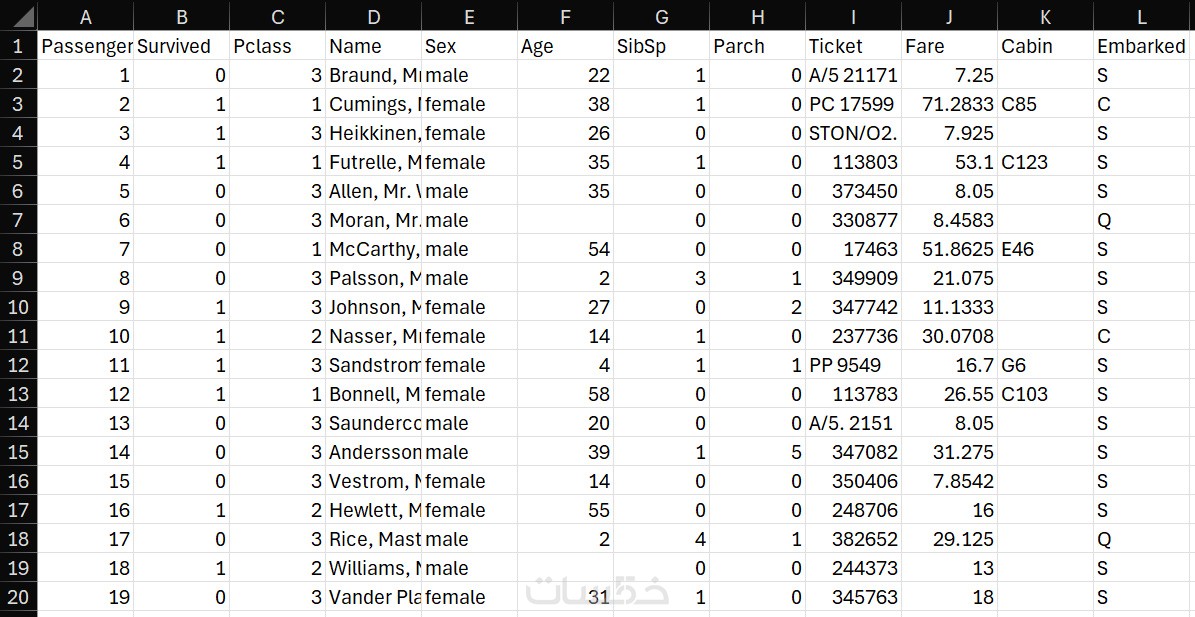

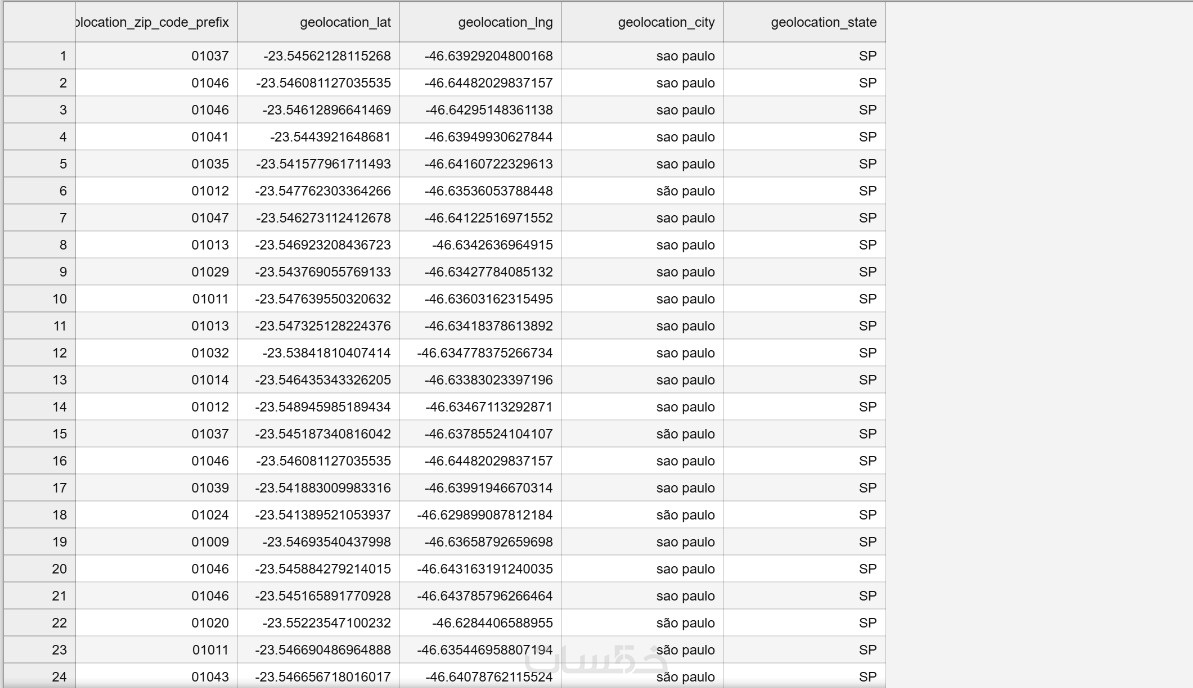

1. ملف البيانات المستخرجة والمنسقة

ستتسلم ملفًا يحتوي على جميع البيانات التي تم جمعها من الموقع المطلوب بصيغة Excel، CSV أو JSON حسب اختيارك، مرتبة في أعمدة وصفوف منظمة لتسهيل القراءة والاستخدام.

2. تقرير مبسط عن عملية الاستخراج

يشمل تفاصيل حول كيفية تنفيذ العملية، عدد الصفحات أو السجلات التي تم جمعها، وأي ملاحظات مهمة عن جودة أو تنسيق البيانات.

3. كود Python المستخدم في الاستخراج

أرسل لك الكود البرمجي المستخدم في عملية Web Scraping مع تعليقات توضيحية، لتتمكن من تشغيله بنفسك لاحقًا أو تطويره إذا رغبت (اختياري حسب الطلب).

4. دعم فني بعد التسليم

أوفر لك فترة دعم قصيرة بعد التسليم لتوضيح أي استفسار أو تعديل بسيط على البيانات في حال احتجت لذلك.

ملف بأي صيغة يحتوي على البيانات

• اقدم لك استخراج حتى 2000 من البيانات ضمن الخدمة الأساسي.