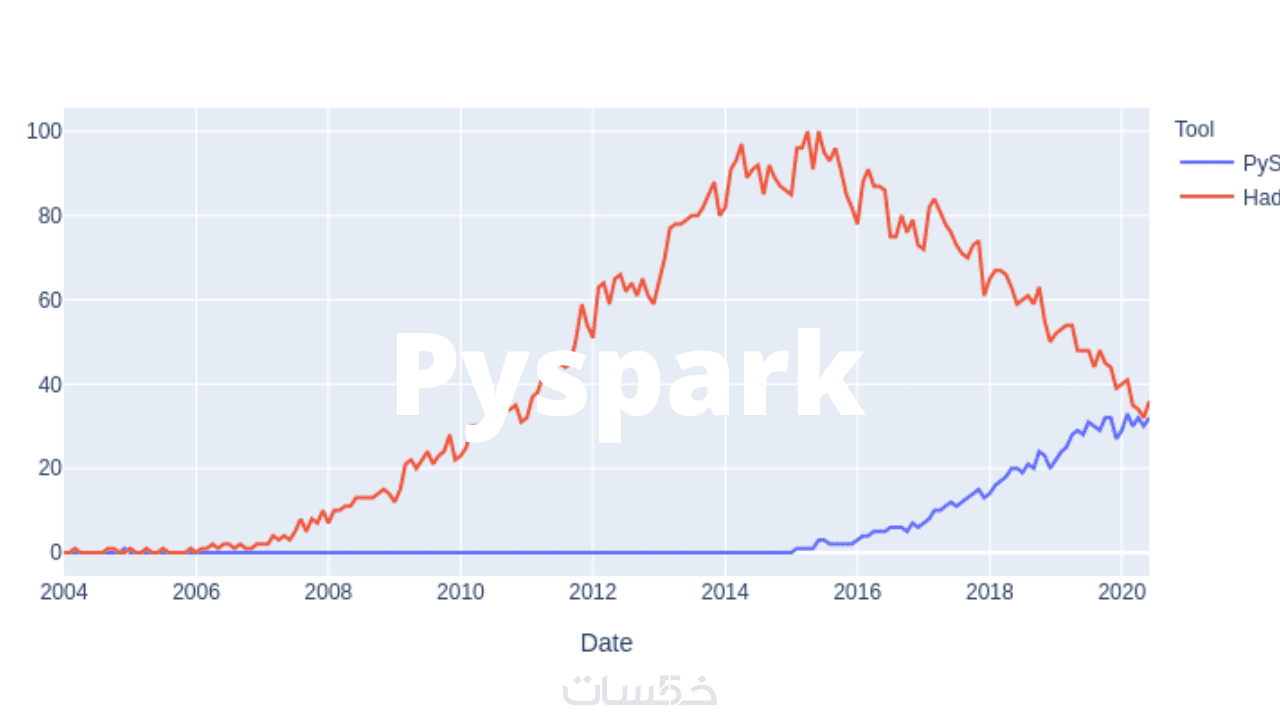

تحليل البيانات بواسطة Spark وHadoop

تحليل البيانات بواسطة Spark وHadoop

عن الخدمة

هل لديك بيانات ضخمة تحتاج إلى تحليل سريع، دقيق، وقابل للتطوير؟

أنا هنا لمساعدتك باستخدام أقوى تقنيات Big Data:

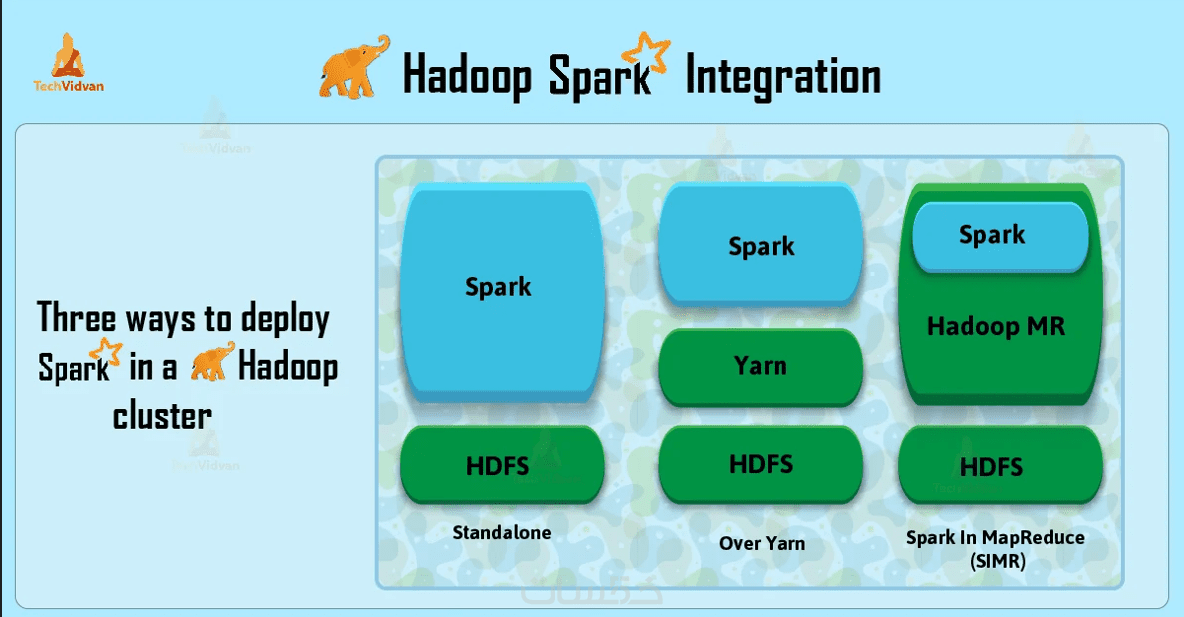

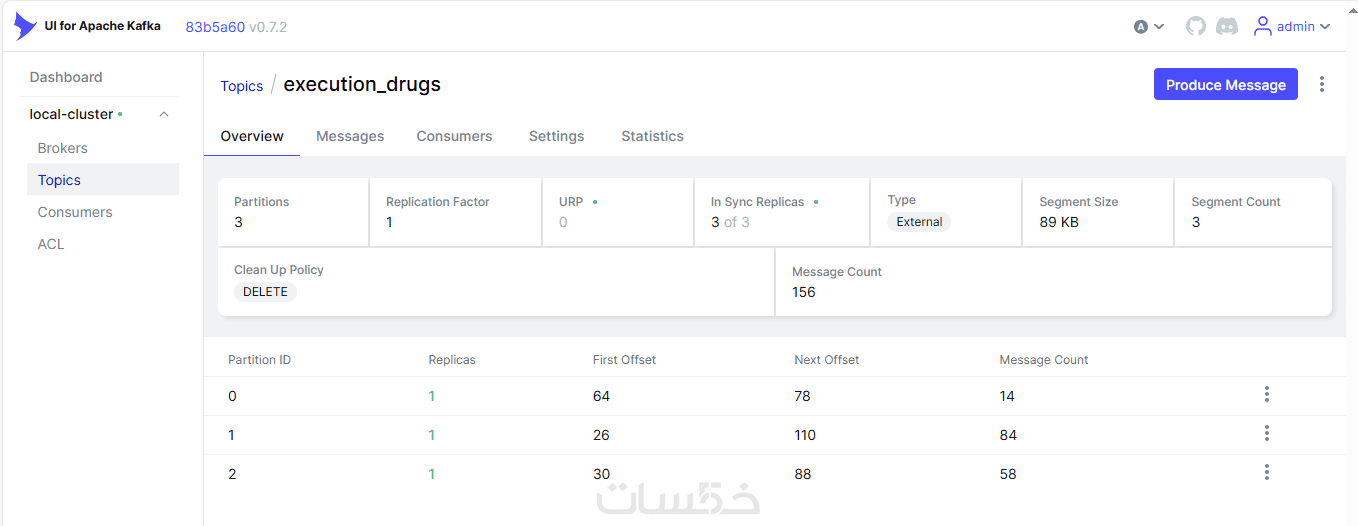

Apache Spark, Hadoop, Hive, PySpark, HDFS, Kafka.

ما الذي أقدمه لك في هذه الخدمة؟

• تحليل البيانات الضخمة مهما كان حجمها (GB / TB)

• تنظيف البيانات (Data Cleaning)

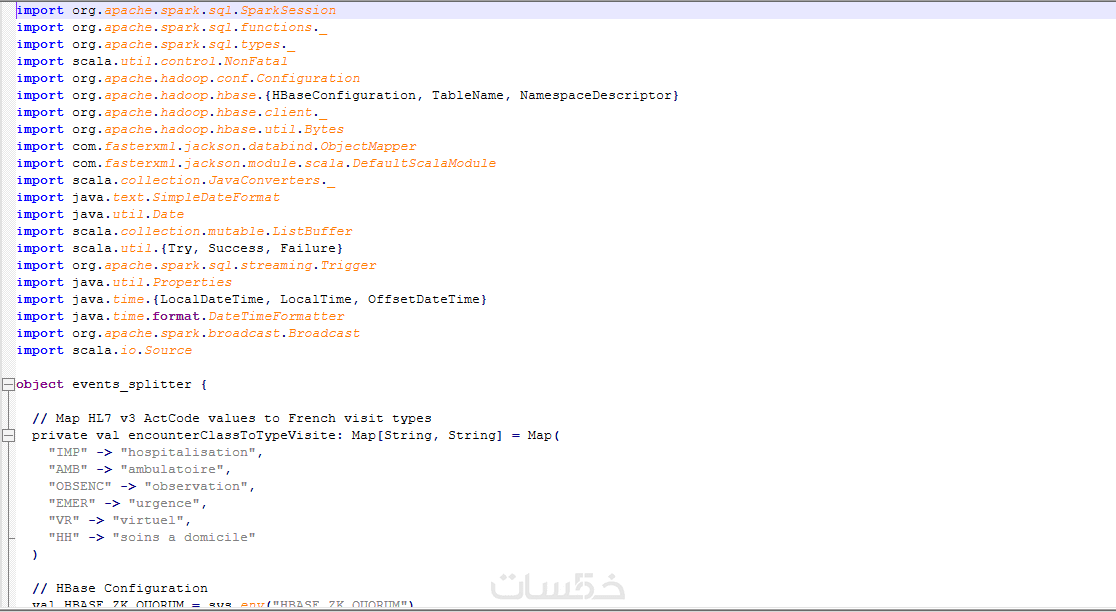

• معالجة البيانات (ETL) باستخدام PySpark / Spark SQL

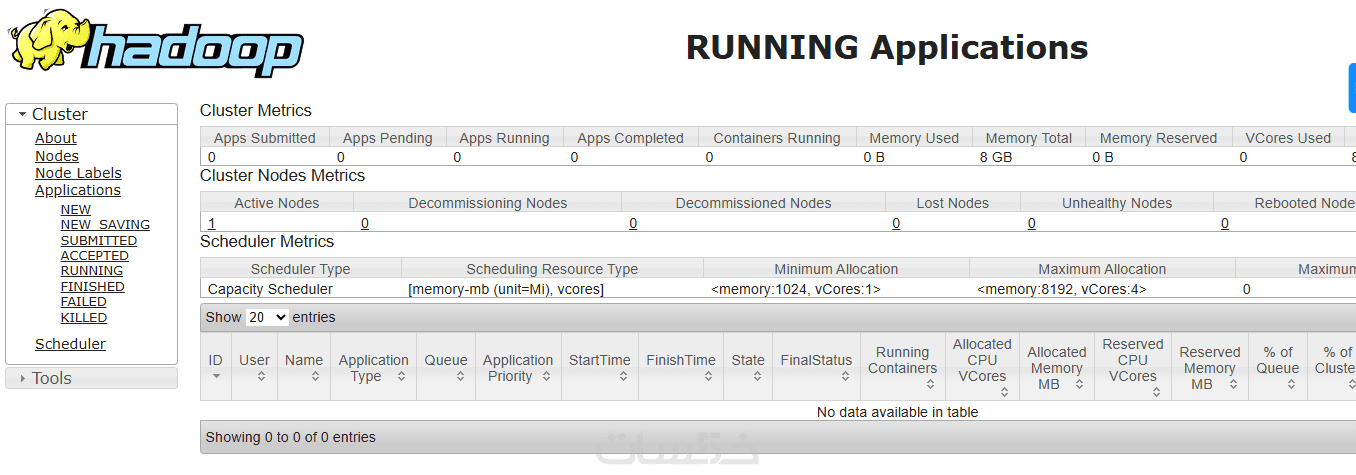

• تحليل بيانات موزعة عبر HDFS أو Cloudera / Hadoop

• معالجة ملفات logs, CSV, JSON, Parquet

لماذا أنا خيارك الأفضل؟

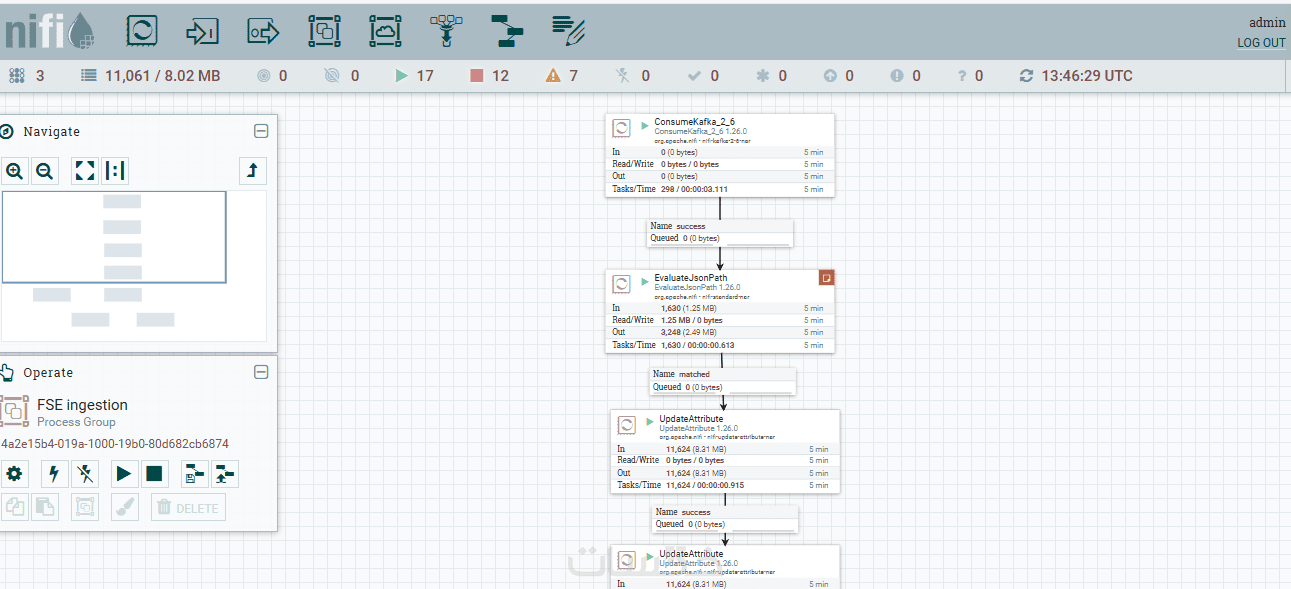

• خبرة عملية قوية في Spark + Hadoop + Hive + Kafka + NiFi

• خبرة طويلة في هندسة البيانات (Data Engineering)

• شرح مفصل للتقرير في حال رغبتك بذلك

نطاق الخدمة الأساسية يشمل:

حجم بيانات يصل إلى 10 – 30 جيجابايت (أو ما يعادلها بعد الضغط)

• Pipeline ETL واحد (استخراج - تنظيف - تحويل - تحميل)

• حساب 3 إلى 5 مؤشرات KPI أساسية