استخراج البيانات من المواقع باستخدام Web Scraping

استخراج البيانات من المواقع باستخدام Web Scraping

وصف الخدمة

هل تحتاج إلى استخراج بيانات من مواقع الويب بطريقة منظمة وسريعة؟ أقدم لك خدمة Web Scraping لاستخراج البيانات المطلوبة وتحويلها إلى ملفات CSV أو Excel أو JSON حسب احتياجاتك، أقدم الخدمة لاستخراج بيانات من موقع او برنامج واحد بحجم 20 ألف صف .

مميزات الخدمة

استخراج البيانات من أي موقع متاح للعامة

يتم بجمع البيانات من المواقع الإلكترونية المتاحة دون انتهاك أي سياسات أو قيود، مع ضمان دقة واكتمال المعلومات المستخرجة. يمكن استخراج بيانات المنتجات، الأخبار، الإعلانات، وغيرها حسب الحاجة.

تصفية وفرز البيانات حسب الطلب

تنظيف وتنظيم البيانات المستخرجة وفقًا لمتطلباتك، مثل إزالة التكرار، تصنيف البيانات حسب الفئات، أو استخراج معلومات محددة فقط، مما يسهل عليك تحليلها والاستفادة منها مباشرة.

تسليم البيانات بتنسيق مناسب مثل CSV, Excel, JSON

وفر لك البيانات في التنسيق الذي يناسب احتياجاتك، سواء كان CSV لسهولة التحليل، Excel لجداول منظمة، أو JSON لدمجها مع الأنظمة والتطبيقات بسهولة.

ما الذي ستستلمه

ملف يحتوي على البيانات المطلوبة بتنسيق CSV أو Excel أو JSON حسب اختيارك.

أوفر لك ملفًا منظمًا يحتوي على البيانات المستخرجة من الموقع المستهدف، بحيث يكون جاهزًا للاستخدام مباشرة. يمكنك اختيار التنسيق الذي يناسب احتياجاتك، سواء كان CSV لتحليل البيانات بسهولة، Excel لإدارتها ضمن الجداول، أو JSON لاستخدامها في التطبيقات والأنظمة البرمجية.

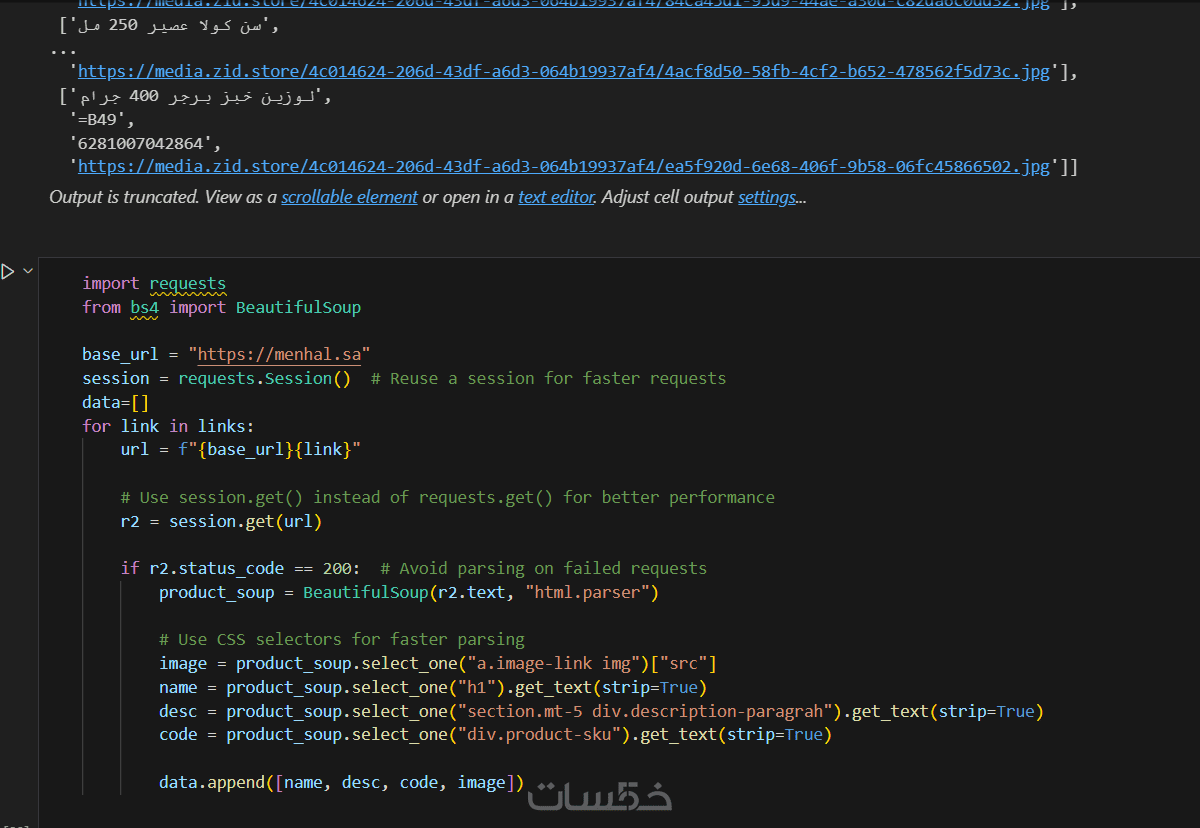

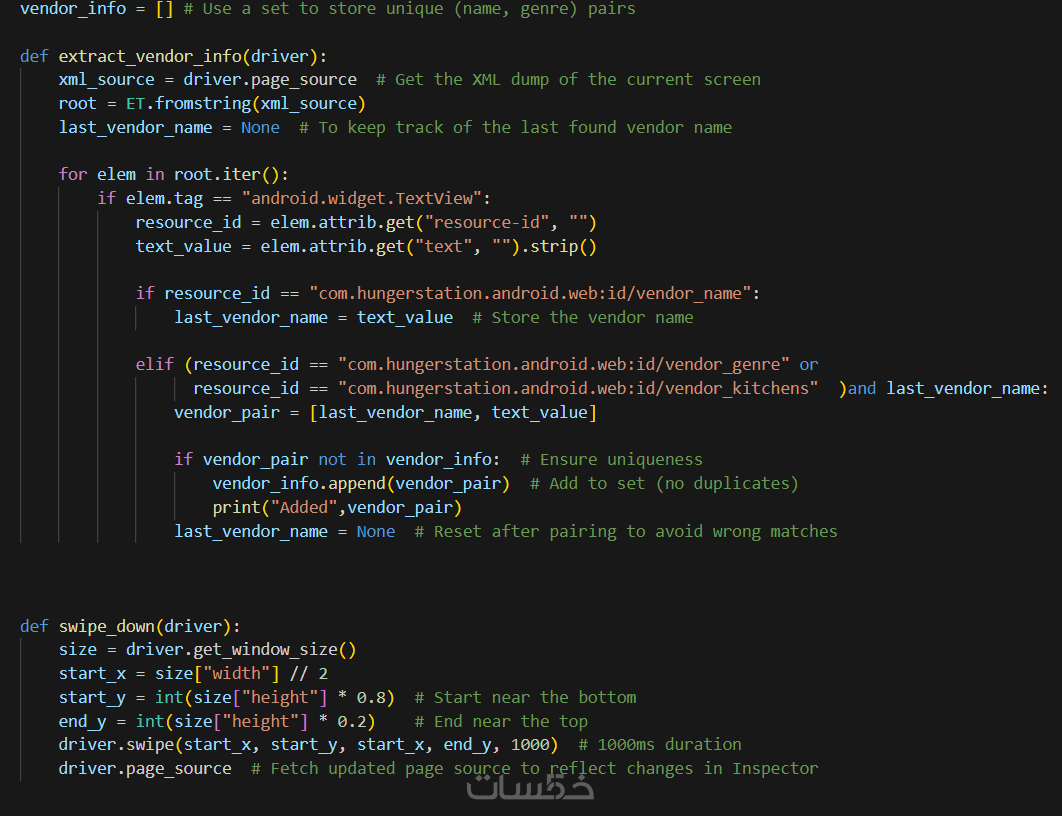

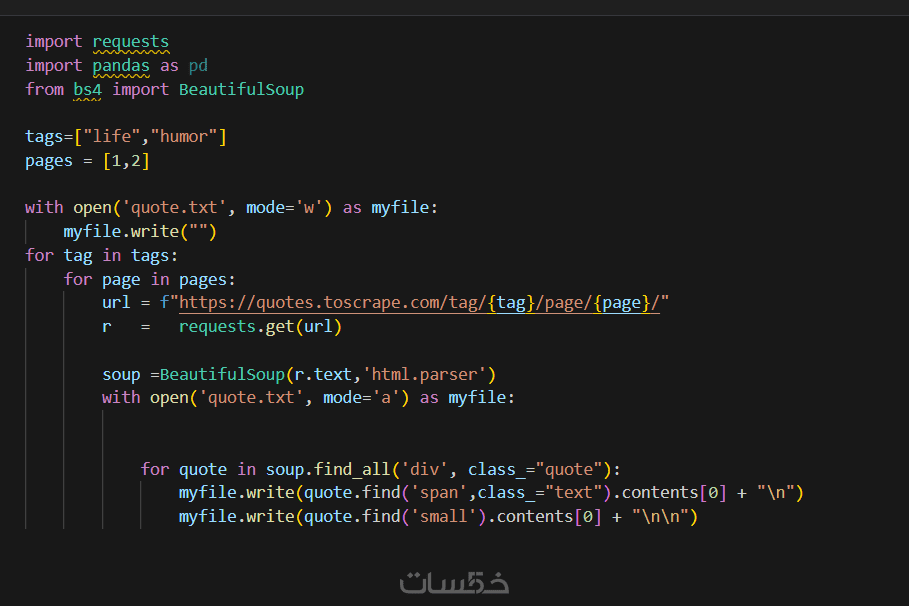

كود Web Scraping مكتوب بلغة Python

سأقدم لك الكود المستخدم في استخراج البيانات، مكتوبًا بلغة Python باستخدام مكتبات قوية مثل BeautifulSoup، Selenium، أو Scrapy، مما يتيح لك إمكانية تشغيله لاحقًا لجلب بيانات جديدة متى احتجت إليها.

تقرير موجز يوضح كيفية تشغيل الكود

سأرفق مع الخدمة تقريرًا مختصرًا يوضح طريقة تشغيل الكود، المتطلبات اللازمة لتشغيله، وكيفية تعديل أي إعدادات أساسية إذا لزم الأمر، لضمان تجربة استخدام سلسة دون أي تعقيدات.

سابقة الأعمال

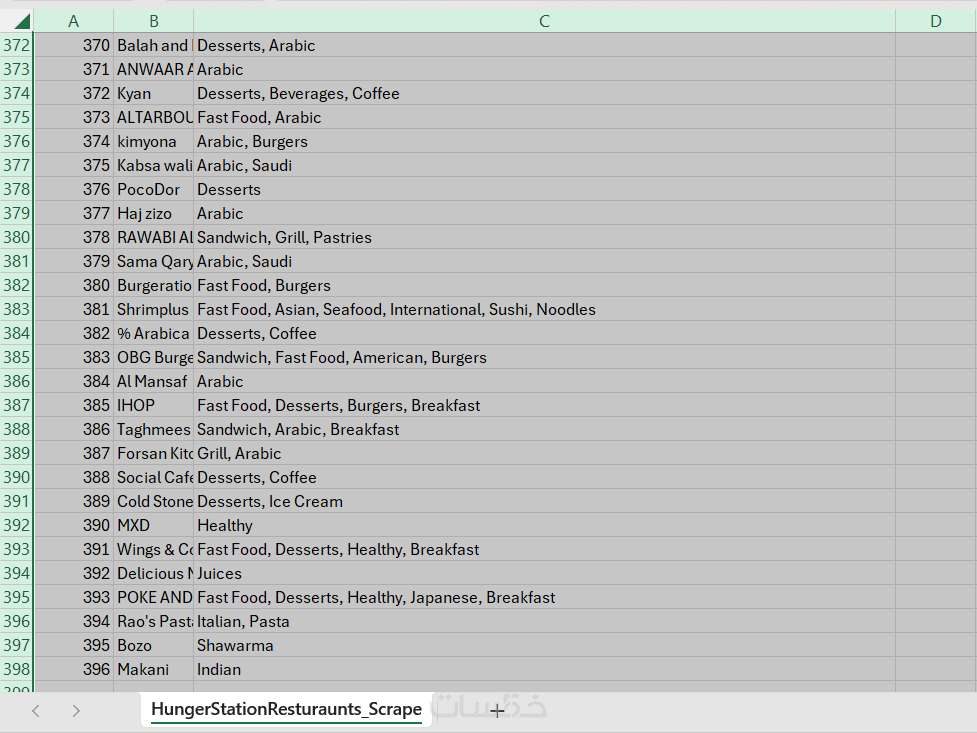

في معرض الاعمال عينة من سابقة أعمالي من تكويد برامج مؤتمته لاستخراج البيانات من مواقع و برامج الموبايل، مثل Hunger Stations, Menhal و Books to scrap يمكنك أيضا رؤية الناتج النهائي من مشروع استخراج البيانات من برنامج Hunger Stations

كلمات مفتاحية

خدمات قد تنال إعجابك

شراء الخدمة

سعر الخدمة

$5.00

تطويرات اختيارية

انشاء DataBase باستخدام mySQL

5.00

|

بطاقة الخدمة

بطاقة الخدمة

شراء الخدمة

سعر الخدمة

$5.00

تطويرات اختيارية

انشاء DataBase باستخدام mySQL

5.00

|